注目記事

連載

Pick up (PR)

セミナー情報

2024年 4月8日(月)~26...

オンライン

[4/8-4/26配信]セールステックセミナー

【Jump Over】 顧客ニーズの理解で効果的なセールスを

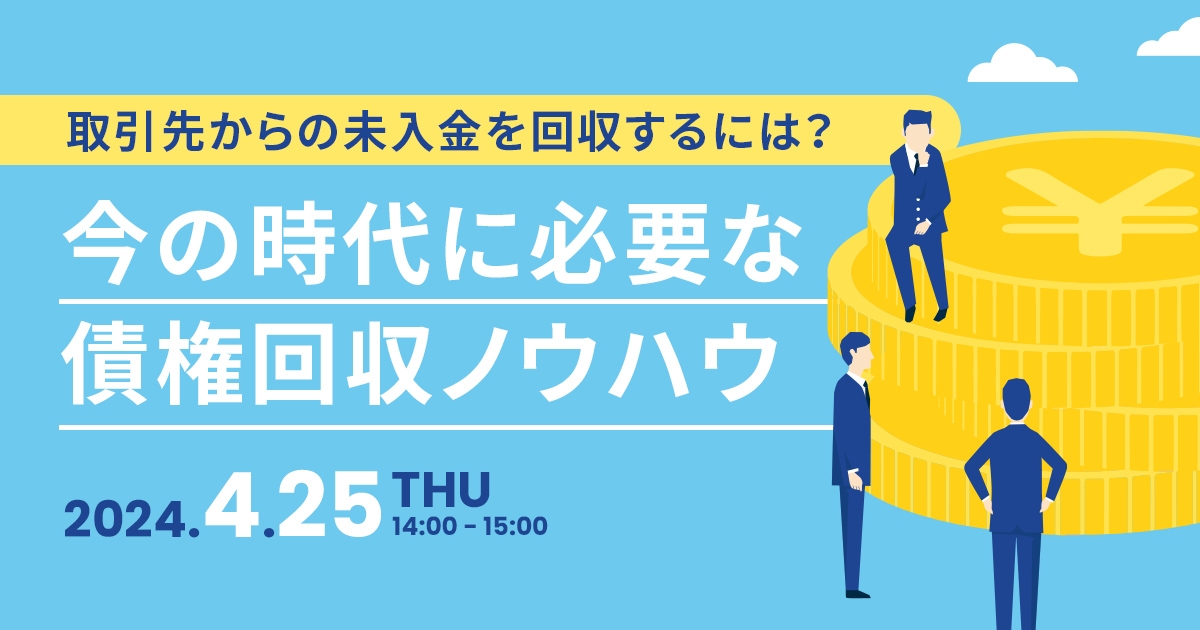

2024/4/25(木)14:00 - 15:00

オンライン

今の時代に必要な債権回収ノウハウ

取引先からの未入金を回収するには? 今の時代に必要な債権回収ノウハウ

2024年4月18日(木)13:00~14:00

オンライン

新年度のバックオフィスDX

来年こそはノンストレスで過ごす!新年度のバックオフィスDX

4月18日(木) 16:00-17:00

オンライン

サイバーリスクの削減法に迫る