インテルは、同社のニュースリリースにおいて、さまざまなアプリケーションの複雑なディープラーニング・モデルを実行する環境として、同社のAIテクノロジーがどのように活用されているかを紹介した。

22日に公開されたMicrosoftのブログでは、インテル FPGAを活用したリアルタイムAI実現のためのシステムである「Project Brainwave」がディープラーニング・モデルに柔軟に対応し、優れたパフォーマンスを実現することが紹介された。また、同社は半導体テクノロジーの最新事例を紹介するシンポジウム「Hot Chips 2017」において、FPGAベースのディープラーニング・プラットフォームのデモを行った。

Microsoftは早い時期から自社のパブリック・クラウド・インフラストラクチャーに FPGAを導入しており、インテル Stratix 10 FPGAを使用して実証された最新テクノロジーでは、人間の脳のコンセプトに類似した方法で「思考」を再現するディープ・ニューラル・ネットワーク(DNN)を高速化している。

また、インテルでは、AIの急速な発展で必要とされるワークロード要件を効率的に管理するため、インテル Xeonプロセッサー、インテル FPGA 、インテル Nervana ASIC テクノロジーなどAI市場を進化させる幅広いテクノロジーを提供している。

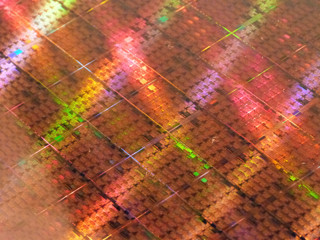

ディープラーニング専用ハードウェア・アクセラレーターに比べ、柔軟性を備えたインテル FPGAは、特定のワークロード要件に応じてハードウェアをカスタマイズ可能で、ディープラーニングのワークロードやモデルに合わせて迅速に再構成できる。インテル Stratix 10 FPGAは、持続的な性能と優れた効率性を提供する堅牢なプロセッサー・ブロックとカスタマイズ性をもたらすプログラマブル・ファブリックで構成されている。

一般的なシリコン(ハードウェア)AI アクセラレーターでは、高パフォーマンス実現のために複数のリクエストをまとめてグループ化する必要があるが、インテル Stratix 10 テクノロジーを活用したProject Brainwaveでは、1回のリクエスト当たり39TFLOPSを超える高いパフォーマンスにより、クラウドにおけるリアルタイムAI演算処理が大幅に向上した。インテル Stratix 10 FPGA は、クラウドにおけるリアルタイムAI演算性能を向上し、低レイテンシー・高いパフォーマンスを実現するとともに、AIリクエストのバッチ化を解消する。

Microsoft Research NExT の主任エンジニアである Doug Burger氏は、次のように説明している。「インテル FPGA の柔軟性を活用することで、最新のイノベーションを迅速に取り込みつつ、多くの ASIC ベースのディープラーニングと同等、またはそれ以上のパフォーマンスを提供しています」

なお、Microsoftは現在、AzureクラウドへのProject Brainwaveの導入に取り組んでおり、完了するとAzureユーザーは複雑なディープラーニング・モデルを高いパフォーマンスで実行可能となる。インテル テクノロジーを搭載したマシン・ラーニング・プラットフォームは、モデル・トレーニングの高速化、迅速なスコアリング、スケーラビリティーの高いインフラストラクチャーを通じて、単なるデータから実用的な洞察を導き出す処理を支援する。カスタマイズ性に優れたプログラマブルなインテル FPGA は、低レイテンシーで精度も柔軟に選択でき、最新のインテル Xeon スケーラブル プロセッサーと組み合わせることで、インテル Xeon プロセッサーのみの場合と比較して、ディープラーニングの推論処理における消費電力当たり性能が向上するということだ。