Oakforest-PACSのシステム構成

Oakforest-PACSは富士通が納入したシステムで、次の写真に示す富士通「Primergy CX1640 M1」サーバを8208台使っている。写真の左側のオレンジ色の丸いものがASETEKの水冷コールドヘッドである。この下にKNLがあり、黒く写っているパイプを通る水で冷却している。

そしてKNLの上下の位置には、6枚のDDR4 DIMMが写っている。右側の裏面が見えている基板は、Omni-Pathのネットワークインタフェースカードである。

そして、次の写真は、このサーバボードが左右から4枚ずつ挿入できる「CX600 M1」シャーシである。中央に見えるファンは1方向に空気を送っており、空気は左右の2台のサーバを直列に通過することになるが、KNLの熱は水冷で処理されており、空気で運ぶのはDDR4 DIMMとOmni-PathのNICの熱だけであり、2枚のサーバを直列にしても空気で冷却できるとのことである。

そして、Oakforest-PACS全体では、このCX600 M1シャーシを1026台使用している。

Oakforest-PACS全体は102本のラックで構成されているが、KNLの計算ノードを収容するラックは、69本である。したがって、各ラックには、15台のCX600と4台の48ポートのOmni-Pathのエッジスイッチが収容されていると考えられる。

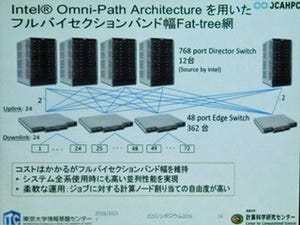

システムのネットワークは、Omni-Pathを使うFat-Tree接続で、48ポートのエッジスイッチ362台と768ポートの12台のディレクタスイッチで構成されている。エッジスイッチは24ポートをダウンリンクに使い、24台のCX1640 M1サーバを接続する。残る24ポートはアップリンクで、各2ポートを12台のディレクタスイッチに接続する。

ディレクタスイッチは、362台のエッジスイッチから2本ずつ接続されるので、これで724ポートを使うことになり、44ポートが残る計算になる。この図には書かれていないが、この12ディレクタスイッチ×44ポートを使って、ストレージ、外部接続のネットワーク、ログインノードなどが接続される。

このFat-Tree構成は、使用するポートの衝突がなければ、全部の計算ノードが全速で通信を行っても耐えられる通信バンド幅を持っているスパコン向きのネットワークとなっている。

なお、TOP500 5位のCoriはCray製のXC40スパコンであり、Cray独自のネットワークを使っているので、Oakforest-PACSは、世界で最大のIntelのOmni-Pathネットワークを使うシステムとなっている。

|

|

|

|

Oakforest-PACSの計算ノード間ネットワーク。Omni-Pathの48ポートエッジスイッチを362台、768ポートのディレクタスイッチを12台使用している (出典:JCAHPCの中村施設長の発表資料 |

768ポートのディレクタスイッチの背面。薄い青のケーブルはエッジスイッチをつなぐ光ケーブル |

Oakforest-PACSは、ストレージとして、940TBの容量のDataDirect Networks(DDN)のIME14Kバーストバッファと26.2PBのDDNのSFA14K並列ファイルシステムを接続している。バーストバッファはファイルのキャッシュで、細切れに行われた書き込みをバッファに入れてまとめて、大きなブロックにして並列ファイルシステムに書き込むことにより、高い実効バンド幅のストレージを実現している。バーストバッファの総バンド幅は1.56TB/sである。

Oakforest-PACSシステムで、UPS(無停電電源)が付けられているのは、並列ファイルシステムとログインノードや管理系だけであり、計算ノード、Omni-Pathスイッチ、バーストバッファなどは、停電が起こると電源が切れてしまうという構成になっている。したがって、停電が起こると、実行中の処理は異常停止してしまうが、復電すれば、チェックポイントから以前の状態を読み出して、処理を再開できるようになっている。

Oakforest-PACSの冷却

TOP500のリストでは、Oakforest-PACSの消費電力は2.72MWとなっており、これは12.66MWの京コンピュータの20%強の消費電力である。HPLの実行時には計算ノードはフル稼働であるが、ストレージはほとんど必要ないので、これらは止めた状態で、かつ、冷却系などは含まないスパコン本体だけの電力となるので、次に述べる公称電力より少ない消費電力になっている。

一方、冷却などを含めたOakforest-PACSシステム全体の公称の消費電力は4.2MWとなっている。しかし、最近の運用の感触では、もう少し少なく4MWくらいではないかという。とは言え、4MWは相当な電力であり、大規模スパコンでは、常に、冷却が問題となる。

前にも触れたが、高発熱の計算ノードのKNLは、ASETEKの水冷コールドヘッドで冷却している。冷却水は、次の写真の左端に見えるラックの柱のような部分に収められたCDU(Coolant Distribution Unit)から供給される。そして、黒いパイプを経由してCX1640 M1サーバに接続されている。

そして、温まった1次冷却水はCDUに戻り、そこから、ラックの天井に付けられている熱交換器に送られ、2次冷却水で冷やされてCDUに戻るというループになっている。2次冷却水は、室外のクーリングタワーで冷却されて熱交換機に戻るというサイクルになっている。

また、CX1640 M1サーバのメモリDIMMやOmni-Path NIC、電源などは空冷であるが、計算ノードラックは、リアドア冷却を使っており、インラックCDUを冷やす2次冷却水と同じ水を使って、サーバからの排気を冷やして放出している。

一方、DDNのストレージやOmni-Pathのディレクタスイッチは、普通の空冷であり、熱をデータセンターの空気へ排出する。JCAHPCセンターのコンピュータ室は、壁際に置かれたCRAC(Computer Room Air Conditioner)で室内の空気を吸い込んで冷やし、床下を通して空冷のラックのコールドアイルに供給するという方法で冷却を行っている。

Oakforest-PACSのお値段は?

Oakforest-PACSの調達は5年間の保守を含めて72億円という。これは、電気代やセンターの人件費などは含まない値である。したがって、これらを含めると、5年間の総コストは100億円を若干上回ると思われる。

京コンピュータを調達費は1000億円あまりである。この金額は、建物の建設費は、ハードの開発費などを含めた金額であるが、京コンピュータと比べるとOakforest-PACSは1/10程度の費用で実現されている。

この費用であるが、予算額の大きい東大が2/3、筑波大が1/3を負担しているという。しかし、このラックは東大、こちらは筑波大というようなハードウェアレベルの切り分けは行わず、CPU時間の配分を2対1にしているという。したがって、東大のユーザでも筑波大のユーザでも、全部の計算ノードを使う大規模計算を行なうことが可能であるという。