第36回の「領域分割(3)」から少し間があきましたが、今回は「Semantic Image Segmentation」についてです。Convolutional Neural Networks(CNN)をベースとした手法をいくつか紹介したいと思います。

Fully Convolutional Networksを用いた手法

ディープラーニングがブレークスルーとなり、物体認識の認識精度が飛躍的に向上しました。物体認識に用いられるCNNは図1の様に、出力層付近で全結合層を介しmクラスの物体識別結果(y1,y2,…, ym)を出力します。

Semantic Image Segmentationの分野も、CNNの一種であるFully Convolutional Networks(FCN)などの登場により飛躍的に性能が向上しました (参考文献[1])。FCNは、前述のCNNの全結合層をアップサンプリングした畳み込み層に置き換えたネットワークです。ピクセルごとにラベル付けされた教師データを与え学習することで、入力画像の各画素のラベル(物体種別)を推定することができます(図2)。

Deconvolution Networkを用いた手法

また、Deconvolution NetworkによるSemantic Image Segmentationも提案されています(参考文献[2])。この手法では、Convolution networkと、その逆のDeconvolution networkを組み合わせることで精度の高いラベリング結果を得ることに成功しています(図3、図4)。

Fully Convolutional NetworksとConditional Random Fieldを用いた手法

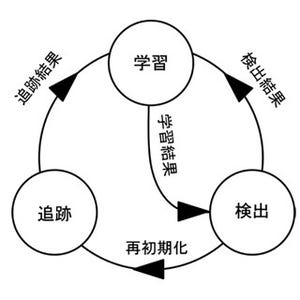

FCNと第36回で紹介したConditional Random Field(CRF)を組み合せた手法です(参考文献[3])。CRFにおける平均場近似の推定処理をRecurrent Neural Network(RNN)とみなして定式化し、FCNとCRFを同時に学習することで高精度なSemantic Image Segmentationを実現しています(図5)。

第34回の記事で紹介したオックスフォード大学のSemantic Image Segmentationのデモページで気軽に試して見ることができます。

高精度なSemantic Image Segmentationを実現できれば、自動車の自動運転などさまざまな分野に応用できる可能性があります。従来は、白線を検出し、画像の広範囲をスキャンすることで車両を検出し、同様に画像の広範囲をスキャンして歩行者を検出し、という処理を行っていました。Semantic Image Segmentationではこれらの処理を同時にできる訳です。興味のある方は参考文献を是非読んでみて下さい。また、ソースコードも公開されていますので、実際に動かしてみて下さい!

参考文献

[1] J. Long, E. Shelhamer, T. Darrel: Fully Convolutional Networks for Semantic Segmentation. CVPR2015 [2] H. Noh, S. Hong, B. Han: Learning Deconvolution Network for Semantic Segmentation. ICCV2015 [3] S. Zheng, S. Jayasumana, B. R. Paredes, V. Vineet, Z. Su, D. Du, C. Huang, P. H. S. Torr: Conditional Random Fields as Recurrent Neural Networks. ICCV2015

著者プロフィール

樋口未来(ひぐち・みらい)

日立製作所 日立研究所に入社後、自動車向けステレオカメラ、監視カメラの研究開発に従事。2011年から1年間、米国カーネギーメロン大学にて客員研究員としてカメラキャリブレーション技術の研究に携わる。

日立製作所を退職後、2016年6月にグローバルウォーカーズ株式会社を設立し、CTOとして画像/映像コンテンツ×テクノロジーをテーマにコンピュータビジョン、機械学習の研究開発に従事している。また、東京大学大学院博士課程に在学し、一人称視点映像(First-person vision, Egocentric vision)の解析に関する研究を行っている。具体的には、頭部に装着したカメラで撮影した一人称視点映像を用いて、人と人のインタラクション時の非言語コミュニケーション(うなずき等)を観測し、機械学習の枠組みでカメラ装着者がどのような人物かを推定する技術の研究に取り組んでいる。

専門:コンピュータビジョン、機械学習