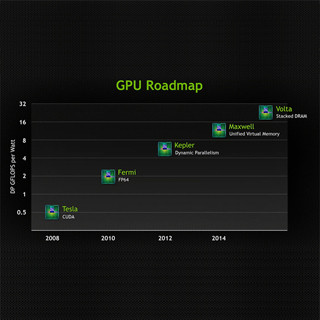

NVIDIAは6月18日(独自間)、独ライプチヒで開催されている「INTERNATIONAL SUPERCOMPUTING CONFERENCE(ISC'13)」において、2012年にGoogleが構築した過去最大規模のものを6.5倍に向上させたヒトの脳の学習方法をモデル化できる人工ニューラルネットワークをスタンフォード大学の人工知能ラボのディレクタであるAndrew Ng氏らと共同で構築したと発表した。

コンピュータでニューラルネットワークを構築すると、「学習」によって脳の挙動をモデル化し、人間と同じように物体や文字、音声、オーディオなどを認識することが可能になるが、大規模なニューラルネットワークの構築には膨大なコンピュータ資源を必要としていた。実際に、Googleのニューラルネットワークは、CPUベースのサーバを約1000台、CPUコアを約1万6000個ほど使用することで、さまざまなYouTube動画から猫を認識することに成功していた。

今回のネットワークでは、生み出されるビッグデータの処理をNVIDIA GPUで処理することで、3台のサーバ(16台のNVIDIA GPU)でGoogleを上回る規模のネットワークを構築することに成功したという。このニューラルネットワークは、パラメータ数が112億で、2012年にGoogleが発表したネットワークの6.5倍におよぶという。

同社では、ニューラルネットワークを大型化してパワフルにすれば、物体の認識といったタスクの精度があがり、人間に近い挙動をコンピュータでモデル化することが可能になると説明している。