SC16において、「Post Moore's Era Supercomputing in 20 Years」と題するパネルディスカッションが行われた。パネリストは、ローレンスバークレイ国立研究所のJohn Shalf氏、東工大の松岡聡氏、ETH ZurichのMatthias Troyer氏、コロンビア大のSebastien Rumley氏、ジョージア工科大のTom Conte氏、IBMのJun Sawada氏の6名で、モデレータはオークリッジ国立研究所のJeffrey S Vetter氏とローレンスバークレイ国立研究所のGeorge Michelogiannakis氏である。

この手のパネルでの常連のIntelのShekhar Borkar氏は6月にリタイヤされたとのことで、もうBorkar氏の意見を聞けないと思うと残念であった。

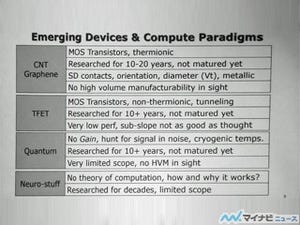

このパネルの2日前に15人の若手の研究者が考えを述べる「Post Moore's Era Supercomputing(PMES)」のワークショップが開かれたのであるが、量子コンピューティング、ニューロモルフィックコンピューティング、確率的コンピューティング、ヘテロジニアス・再構成可能コンピューティングなど広い範囲のアイデアが出された。

|

|

|

Vetter氏が作成したPMESワークショップのまとめ。15人が量子コンピューティング、ニューロコンピューティング、確率的コンピューティングなど広い範囲の大きく異なる解決案を提案した (出典:Vetter氏のまとめのスライドを撮影したもの) |

しかし、どの程度の性能が得られるか、システムバランスはどうなるのか。実用アプリを動かす上でのサクセスストーリー、ソフトウェアスタックをどうするか、アプリの移植性などの点では実用までにはギャップのあるものであった。

とVetter氏はPMESのワークショップを総括した。

|

|

|

パネルディスカッションのメンバー。左から、Jeffrey Vetter氏、George Michelogiannakis氏、John Shalf氏、Tom Conte氏、松岡聡氏、Matthias Troyer氏、Jun Sawada氏、Sebastien Rumley氏 |

IEEEのRebooting ComputingとIRDSを率いるConte氏は、デバイスの改良だけに頼るLevel 1はあり得ない、非フォンノイマンのLevel 4はデバイスからアルゴリズムまで全部が変わるので、あまり現実的でない。アーキテクチャを変えるGPUのようなLevel 3のアプローチは、可能性がある。しかし、マイクロアーキテクチャ以下は変えるが命令アーキテクチャは踏襲するLevel 2が一番可能性が高いと述べた。

|

|

|

デバイスの改良だけに頼るLevel 1はダメ、全部を変更するLevel 4も現実的でない。命令アーキテクチャを変えるLevel 3は可能であるが、マイクロアーキテクチャを変えるLevel 2が現実的 (以下の図は、それぞれのパネリストが示したスライドを撮影したもの) |

このLevel 2のアプローチは、1995年のスーパスカラの時に行われ、ムーアの法則の単なる延長と比べて、プロセサ性能の伸びを大きく改善したアプローチである。

Level 2のアプローチで、エキゾチックなテクノロジを使いこなす。例えば、電源電圧を半減し、エラーを許容する低電力ゲートの使用、超電導素子の使用、断熱的可逆ロジック、それらの組み合わせやその他の回路的なアイデアの使用。これらのテクノロジを使うためにはマイクロアーキテクチャの変更は必須である。

このアプローチでは、命令アーキテクチャは変わらないので、昔のレガシーなプログラムも動作する。しかし、マイクロアーキテクチャは変わり、最適ポイントも変わるので、チューニングはやり直す必要がある。

Level 2のアプローチの実現であるが、クラウドの普及がコモディティの技術を改善し、それがHPCを改善するという流れになると考えているという。

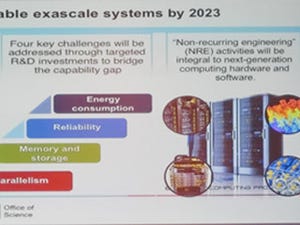

John Shalf氏は、改善の方向としては、アーキテクチャや実装を改善する横方向と、新材料や新デバイスを使う縦方向があるという。しかし、新材料や新デバイスの開発は時間が掛かるので、最初の10年はより効率の高いアーキテクチャとパッケージングで性能の伸びを実現する。そして、次の10+年を新材料を使うTunnel FET、Photonic IC、カーボンナノチューブなどの新デバイスを使って乗り切る。

図で、斜め右上の方向に書かれているデータフローコンピューティング、量子コンピューティングなどは、現在の問題をより高速で解くというよりは、新たな問題を解くのに使われる事になると見ているという。

|

|

|

改善の方向としては、アーキテクチャや実装を改善する横方向と、新材料や新デバイスを使う縦方向がある。新材料、新デバイスの開発は時間が掛かるので、最初の10年は横方向の改善を使う。その後の10+年は縦方向の改善を使えば、20年間の進歩ができる。斜め右上のエキゾチックなアプローチは、新しい問題を解くために使われる。 |

現在は、物性と、デバイスの開発、システムやアーキテクチャの分野の研究開発は分離されているが、このような進歩を実現するには、基礎的な物質科学からデバイス物理、デバイス開発、ヘテロなコンポーネントのインテグレーション、システムアーキテクチャ、そしてプログラミングパラダイムまで、マルチスケールのコデザインが必要になるという。

松岡先生は、Flopsに頼るのではなく、Byteを使うコンピューティングが必要になると説く。3D実装などを含めて、トランジスタ数は2040年まで増加し続けるが、消費電力の点で、全部のトランジスタを同時には動かしてFlopsを上げることはできない。しかし、3D実装と低電力のNVMの実用化で、メモリ容量とバンド幅は伸ばせる。従って、Flopsで処理性能を上げるのではなく、メモリ容量とバンド幅で性能を上げるアルゴリズムが必要という。

そして、2025年頃には、恐竜が絶滅したように、Flops中心のメニーコア時代は終わり、ポストムーア時代はByte中心のアルゴリズム、ソフトウェア、ハードウェアの時代になる。これはプログラミングパラダイムが変わってしまうディスラプティブ(disruptive:破壊的)なチェンジとなるという。