2016年4月に開催された「GPU Technology Conference(GTC 2016)」において、NVIDIAのJen-Hsun Huang CEOは、基調講演の中でディープラーニング用のスーパーコンピュータ(スパコン)「DGX-1」を発表した。このスーパーコンピュータは、NVIDIAの次世代GPUである「Tesla P100(Pascal)」を8台搭載し、ディープラーニングで使われるFP16(半精度)の演算なら170TFlopsという驚異的な性能を持つ。

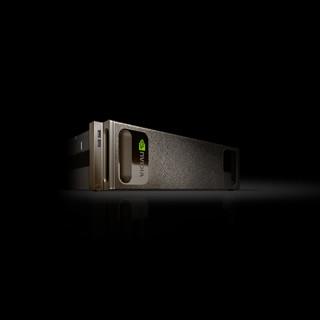

写真を見てもこの箱のサイズの感覚が掴みにくいが、幅が444mm、高さが131mm、奥行きが866mmといういわゆる3Uの箱である。仮に19インチラックにフルに詰め込めば14台を収容することができる計算になるが、1台の消費電力は3.2kWであり、14台では44.8kWになってしまう。通常のサーバルームでは10KW/m2を超える発熱は冷却が難しいので、DGX-1自体は空冷であるが、多数台を設置する場合はリアドア水冷のラックなどが必要になりそうである。

なお、上の写真はDGX-1の前面側からみた写真で、前面は梨地のパネルのように見えるが、実は、この部分は細かいハネカム構造のパネルで空気が通るようになっており、通常のサーバのように前面から吸気し、背面から排気する構造になっているという。

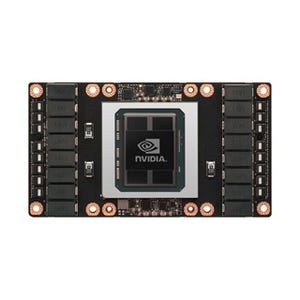

次の図はDGX-1を主要パーツに分解して展開した図で、中央がP100 8台を載せるマザーボードとそれに搭載されるP100 GPUである。また、マザーボードの右端には、クワッド100Gbit/sのInfiniBandとデュアル10Gbit Ethernetのネットワークインタフェースカード(NIC)が搭載されている。そして、マザーボードの右にXeon 2個を載せるCPUモジュールが配置されて、左には7TBのSSDと3.2kWの電源が配置されている。

しかし、NICの右側のコネクタは筐体の背面から突き出す必要があるし、Xeonのフィンの向きからは写真の奥行き方向に風が流れるはずである。そう考えると、このまま、コンポーネントを中央側にまとめた形ではうまく行かない気がするのであるが、どうなっているのであろうか?

マザーボードの配置を見ると、8台のP100は近接した位置に配置され、NVLINKの配線が短くなるようしていることが分かる。

DGX-1の性能であるが、単純なピークFlops値の比較では、DGX-1はXeon E5-2697v3のデュアルソケットのサーバと比較して56倍高性能であり、ディープラーニングの学習では75倍性能が高い。

DGX-1はFP64(倍精度浮動小数点)演算でも42.4TFlopsという高いピーク性能を持ち、19インチラックに半分程度の台数を搭載すればTop500にランクインできる立派な科学技術用スパコンになるのであるが、現在は、NVIDIAは「NVIDIA DeepLearning SDK」や「DIGITS GPU Trainingシステム」と組み合わせて、すぐに使えるディープラーニング用スパコンとして販売している。

お値段は12万9000ドルで、米国では、今年の6月から販売される予定である。