詳細説明その1 - I/O Intensiveな用途向けにIntel C2000ファミリーを投入

続いては基調講演の内容について、もう少しBreak Downした形での説明が行なわれた。まずはJason Waxman氏(Photo15)から、"Architecting Cloud Infrastructure for Future"と題した講演が行なわれた。まず氏はWorkload Optimizationについて語り、直近と今後のサーバの負荷動向の予測を簡単に示した(Photo16)上で、これを馬鹿正直に実装したら死んでしまうわけで、きちんと要求を分析した上で、それぞれに応じた対応が必要である、とした(Photo17)。実はこうした内容に対して、既にIntelはソリューションを提供をしているとしており、幾つかの事例が示された(Photo18)。こうしたソリューションの一つが2Pサーバ×3を2Uのトレイに収めた製品で(Photo19,20)、Photo13で言えば図の中央よりやや左下あたりに向けた、CPU/MemoryよりもI/O Intensiveな用途向けSolutionということになる。

|

|

Photo16: 簡単に示したと言っても、内容は割ととんでもないというか、何というか。期間が微妙にずれているから単純にはいえないが、ラフに言って毎年50~100%づつ性能を引き上げるか、50~100%の設備増強を必要とするレベル。 |

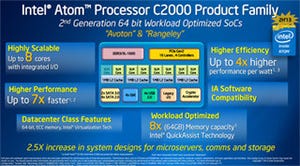

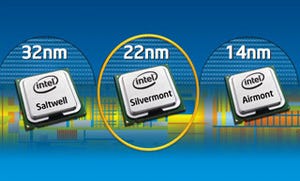

さてこのマーケットに向けてIntelが今年から投入するのが、Intel C2000ファミリーである(Photo21,22)。開発コード名としてはAvotonとRangeleyの2つがあるが、物理的には同一のコアである(違いは後述)。コアそのものはあまり詳しく説明はされなかったものの、

- 2命令のOut-of-Order、Super Scalar

- HyperThreadingはサポートしない

- パイプラインステージは比較的短い

といった特徴が説明された。また4×GbEとあるが、各々は2.5Gbpsの帯域で、合計で10GbEを1ポート構成することになる。ただし現状PHYは外付けで、あくまでも10GbEのMACのみ内蔵という話であった。

さて、これを使うとサーバがどんな風になるのか? というのがこちら(Photo23)。2P Xeonサーバ1枚のエリアに10枚のAvotonブレードを収められるので、2Uトレイに30枚ものAvotonブレードが収容できる事になる。そのAvotonブレードの構造がこちら(Photo24~27)。詳細な消費電力とかはまだ未公開であるが、ものすごくラフに言えば同じトレイを使うわけで、Xeon 2P×3と同クラスの消費電力でAvoton×30Pが実現できることになる。搭載するメモリ量は64GB×30=1920GBにも達し、しかも(Photo21にあるように)それぞれのAvotonが10GbEを持つから、ネットワークの合計帯域も300Gbpsに達する。これはI/O Intensiveな用途には最適と言ってよいだろう。

次の話はComposable Resource。先にRack Levelの最適化で出てきた話である。これは何か? というと、現在は物理的にハードウェアがパーティショニングされているが、これを全部Optical Cableで繋いでしまうことで、Rack内でのパーティショニングを動的に変更できるようにするというもので、更にその先はサブシステム単位でのパーティショニングを可能にするという見通しが語られた(Photo28)。何を言っているかといえば、例えば現状Storageの収まったトレイとCPUモジュールの収まったトレイはそれぞれFCなり10GbEなりで直接接続されているわけだが、これは動的にリソースの分配がしにくい。そこで、全てのトレイから光ファイバーで、ラックの最上段にあるFabricに直接接続する形にすることで、Fabricの構成変更によりモジュール同士の割り当てを自由に変更できるようにしよう、という発想だ。Futureの方は更に進んで、クラウド的にComputation/Memory/Storage/Network/etc...の各リソース単位で自由に再配分しようというものだ。クラウドというよりも、ハードウェアの仮想化に近いかもしれない。これにより、より柔軟性が増える、というのがIntelの主張である(Photo29)。

問題になるのはこのCabling Costだ。光は言うまでもなく既に広く利用されており、FiberChannelや、最近では高速化に伴い10GBASE-KRなどが普及しつつあるが、問題はモジュールもケーブルもさっぱり安くならないことである。これに対するIntelのSolutionが、SiPh(Silicon Photonics)である(Photo30,31)。Intelは昔から色々SiPhに関して取り組みをしており、2009年にもLight Peakという形で発表を行なったり、2010年には50Gbpsの光伝送回路を発表したりしたがが、結局Light PeakはThunderboltという形で銅配線の実装になってしまい、唯一SonyがVAIO ZのPower Media Dockに独自の光コネクタを使った程度でしかなかった。今回Intelはここに、安価に接続できる100GbpsのOptical Moduleを投入することで、一気にRack内の配線を置き換えよう、というものだ。

ちなみにこのSiPhはLight Peakのプロトコルを使っているのかを確認したところ、Waxman氏にはっきりと否定された。単にEthernetを通しているということで、要するに10GBASE-KRということではないかと思う。

最後のテーマがSDI(Software defined infrastructure)である(Photo32)。具体的にどんな方向に向かうのか、というとこんな感じ(Photo33)であるが、ここではじめてWind Riverが姿を現した(Photo34)。2009年にIntelに買収された直後は、この買収の意図がはっきりしなかったが、ここにきてやっと明確になってきた感がある。このマーケットは同社にとってもかなり大きな収入になるとしており(Photo35)、このマーケットを獲得する武器としてSDIを前面に打ち出す方向性を示した。

|

|

Photo32: 理屈は比較的シンプル。ただ中核にOpenStackをすえることの是非はまた別の議論だろうが。 |